Gilaus mokymosi apibrėžimas: principai, technikos ir taikymai

Gilaus mokymosi apibrėžimas: sužinokite pagrindinius principus, efektyvias technikas ir realius taikymus — nuo vaizdų atpažinimo iki natūralios kalbos apdorojimo.

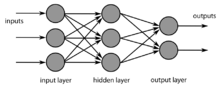

Gilusis mokymasis (dar vadinamas giliuoju struktūriniu mokymusi arba hierarchiniu mokymusi) yra mašininio mokymosi šaka, kuri dažniausiai realizuojama per įvairius neuroninius tinklus. Kaip ir kitose mašininio mokymosi srityse, giliojo mokymosi modeliai gali būti mokomi prižiūrėtu, neprižiūrėtu arba pusiau prižiūrėtu režimu. Dažniausiai tinklai turi daugiau nei du sluoksnius — tarp įvesties ir išvesties sluoksnių būna vienas arba keli paslėptieji sluoksniai, kuriuose informacija transformuojama ir tampa vis abstraktesnė.

Tam tikros užduotys, pavyzdžiui, kalbos, vaizdų ar rašysenos atpažinimas, žmonėms atrodo natūralios ir lengvos, tačiau kompiuteriams jos išspręsti sudėtinga. Daugiasluoksniuose tinkluose informacija kiekviename sluoksnyje apdorojama taip, kad aukštesni sluoksniai išmoksta sudėtingesnių, aukštesnio lygio bruožų ir reprezentacijų.

Gilaus mokymosi modeliai yra įkvėpti biologinių nervų sistemų informacijos apdorojimo idėjų, tačiau jie gerokai skiriasi nuo biologinių smegenų struktūros ir funkcijų — todėl gilaus mokymosi rezultatai ir sprendimo mechanizmai nebūtinai atspindi neurologijos įrodymus.

Pagrindiniai principai

- Hierarchinė reprezentacija: sluoksnis po sluoksnio tinklas išmoksta paprastesnius bruožus (pvz., kraštus) ir vėliau sudėtingesnius objektus ar sąvokas.

- End-to-end mokymas: modeliai gali būti treniruojami tiesiogiai nuo žalių duomenų iki galutinės užduoties, naudojant grįžtamąjį ryšį (backpropagation).

- Parametrų mokymasis: modeliai turi daug parametrų (svorių), kuriuos optimizuojama pagal tam tikrą nuostolių (loss) funkciją.

- Generalizacija: tikslas — išmokti taisykles, kurios veiks ne tik mokymo duomenims, bet ir naujiems atvejams.

Pagrindinės architektūros

- Perceptronų / išėjimo (feedforward) tinklai: paprastos struktūros, naudojamos regresijai ir klasifikacijai.

- Konvoliuciniai neuroniniai tinklai (CNN): ypač tinkami vaizdų apdorojimui, nes naudoja konvoliucijas, kurios aptinka vietinius bruožus ir palaiko translacinį invariantiškumą.

- Rekurentiniai tinklai (RNN) ir LSTM/GRU: sukurti tvarkai bei sekų duomenims (laiko eiliškumai, tekstas, balso signalai).

- Transformerių architektūra: pastaraisiais metais tapo dominuojanti NLP (ir ne tik) srityse, naudoja savęs dėmesio (self-attention) mechanizmus ir leidžia apdoroti ilgus kontekstus efektyviau nei tradiciniai RNN.

- Generatyviniai modeliai: autoencoderiai, variaciniai autoencoderiai (VAE), generatyviniai priešpriešiniai tinklai (GAN) — naudojami duomenų generavimui, rekonstrukcijai, anomalijų aptikimui.

Mokymo metodai ir optimizacija

- Backpropagation: pagrindinis algoritmas gradientams apskaičiuoti ir svoriams atnaujinti.

- Optimizatoriai: SGD, SGD su momentumu, Adam, RMSprop ir kt. — skirtingi optimizatoriai turi įtakos konvergencijai, greičiui ir stabilumui.

- Nuostolių funkcijos: kryžiaus entropija klasifikacijai, MSE regresijai, specializuotos funkcijos (triplet loss, focal loss) specifinėms problemoms.

- Mokymo strategijos: mokymas iš didelių etikečių turinčių rinkinių (supervised), savarankiškas arba savi/kaupiamasis mokymas (self-supervised), pusiau prižiūrimas mokymas, transfer learning (perdėkingas mokymasis) bei fine-tuning iš anksto apmokėtų modelių.

Reguliarizacija ir gerinimo technikos

- Dropout: sluoksnių aktivacijų „išjungimas“ mokymo metu siekiant sumažinti persimokymą.

- Batch normalization: stabilizuoja ir pagreitina mokymą normalizuodama sluoksnių aktyvacijas.

- Svorių mažinimas (weight decay): L2 arba L1 reguliariaizacija, mažinanti per didelius svorius.

- Duomenų papildymas (data augmentation): vaizdams: apvertimai, sukimai, spalvų modifikacijos; tekstui: sinonimų pakeitimai, pertvarkymai — didina duomenų įvairovę.

- Early stopping: sustabdyti mokymą, kai modelio veikla validacijos rinkinyje nustoja gerėti.

Praktinės technikos ir modelių optimizavimas

- Transfer learning: naudoti iš anksto apmokytus modelius (pvz., vaizdų atpažinimui arba kalbos modeliui) ir adaptuoti juos konkrečiai užduočiai.

- Modelio glaudinimas: kvantizacija, pruning, knowledge distillation — sumažina modelio dydį ir reikalingą skaičiavimo galią diegimui į įrenginius su ribotais ištekliais.

- Hipotezių paieška ir eksperimentų valdymas: sistemingas hiperparametrų nustatymas, eksperimentų fiksavimas ir reproducibility praktikos.

Pritaikymai praktikoje

- Kompiuterinė vizija: vaizdų klasifikacija, objektų aptikimas, segmentacija, medicininė vaizdinė diagnostika.

- Garsas ir kalba: automatinis kalbos atpažinimas (ASR), sintezė (TTS), balso atpažinimas, audio klasifikacija.

- Natūralios kalbos apdorojimas (NLP): vertimas, klausimų-atsakymų sistemos, teksto generavimas, sentimentų analizė.

- Autonominiai automobiliai ir robotika: suvokimas, kelio ženklų atpažinimas, navigacija.

- Rekomendacijų sistemos: personalizuotos paskirties turiniui ar produktams rekomenduoti.

- Anomalijų aptikimas: finansinių sukčiavimų, pramoninių gedimų ar kibernetinių incidentų identifikavimas.

Vertinimas, duomenys ir etika

- Vertinimo metrika: accuracy, precision, recall, F1, ROC-AUC, mean IoU (segmentacijai) — parenkama pagal užduotį.

- Duomenų kokybė: tinkamai paruošti ir paženklinti duomenys yra kritiškai svarbūs. Duomenų šališkumas ar netinkamos etiketes gali iškreipti modelio elgesį.

- Privatumas ir saugumas: jautrių duomenų tvarkymas turi atitikti teisės aktus ir etikos normas (anonimizavimas, sutartys, duomenų saugojimas).

- Paaiškinamumas ir atskaitomybė: daug giliųjų modelių yra „juodosios dėžės“ — svarbu sugebėti paaiškinti sprendimus kai jie daro įtaką žmonių gerovei.

Ribojimai ir iššūkiai

- Daug duomenų ir skaičiavimo išteklių poreikis: aukštos kokybės modeliams reikalingi dideli duomenų rinkiniai ir GPU/TPU ištekliai.

- Persimokymas ir prastėjančios generalizacijos rizika: modeliai gali per daug prisitaikyti prie mokymo duomenų ir blogai veikti realiame pasaulyje.

- Šališkumas ir diskriminacija: jei duomenys yra šališki, modelis perpildo šiuos šališkumus.

- Paaiškinamumo trūkumas: interpretacija sudėtinga, ypač kai sprendimai veikia svarbius socialinius ar medicininius rezultatus.

Įrankiai ir diegimas

- Dažniausiai naudojamos bibliotekos ir karkasai: TensorFlow, PyTorch, Keras, JAX ir kt. (parenkami pagal projekto reikalavimus ir komandinius įpročius).

- Diegimas: konteinerizacija (Docker), modelių servinimas (TF Serving, TorchServe), optimizavimas įrenginiams (ONNX, TensorRT) — svarbu atsižvelgti į latenciją, pralaidumą ir resursus.

Ateities kryptys

- Savaiminis mokymasis (self-supervised learning): metodai, leidžiantys išnaudoti didžiulius nepažymėtus duomenų kiekius.

- Mažesni ir efektyvesni modeliai: architektūrų ir mokymo metodų tobulinimas siekiant tų pačių rezultatų su mažesnėmis sąnaudomis.

- Interpretuojamumas ir saugumas: naujos priemonės modelių paaiškinimui, robustiškumo priepuolių (adversarial) mažinimui ir etiškam diegimui.

- Multimodaliniai modeliai: vienu metu apdorojantys vaizdus, tekstą, garsą ir kitas duomenų rūšis integruotoms užduotims spręsti.

Praktiniai patarimai pradedantiesiems

- Pradėkite nuo supratimo apie pagrindines neuroninių tinklų koncepcijas, atlikite paprastus eksperimentus su mažais duomenų rinkiniais.

- Naudokite iš anksto apmokytus modelius (transfer learning), kad greičiau pasiektumėte gerus rezultatus mažesniais resursais.

- Akcentuokite duomenų kokybę ir validacijos procedūras — geras duomenų valdymas dažnai svarbiau už sudėtingus modelius.

- Saugokite eksperimentų reproducibility, fiksuokite parametrus ir versijuokite modelius.

Gilusis mokymasis yra galinga priemonė spręsti sudėtingas užduotis, tačiau sėkmė priklauso nuo sąmoningo duomenų rinkimo, tinkamų architektūrų parinkimo, atsakingo diegimo ir etinio naudojimo. Tolesnis šios srities augimas greičiausiai atneš ir technologinių, ir socialinių iššūkių, todėl svarbu derinti techninį meistriškumą su aiškiais etikos principais.

Daugiasluoksnis neuroninis tinklas.

Klausimai ir atsakymai

K: Kas yra gilusis mokymasis?

A.: Gilusis mokymasis yra mašininio mokymosi rūšis, kai informacijai apdoroti naudojami neuroniniai tinklai, kurie dažnai yra organizuoti taip, kad tarp įvesties ir išvesties sluoksnių yra bent vienas tarpinis (paslėptas) sluoksnis.

K: Kokios skirtingos mokymosi sesijos naudojamos giliajame mokyme?

A: Gilusis mokymasis gali būti organizuojamas į neprižiūrimo, pusiau prižiūrimo ir prižiūrimo mokymosi seansus.

K: Kokios yra užduotys, kurias lengva atlikti žmonėms, bet sunku atlikti kompiuteriams?

A.: Tokias užduotis, kaip kalbos, vaizdų ar rašysenos atpažinimas ir supratimas, žmonėms atlikti lengva, o kompiuteriams - sunku.

K: Kas vyksta su informacija, kai ji apdorojama daugiasluoksniame neuroniniame tinkle?

A: Daugiasluoksniame neuroniniame tinkle apdorojama informacija su kiekvienu papildomu sluoksniu tampa vis abstraktesnė.

K: Kuo įkvėpti giliojo mokymosi modeliai?

A.: Gilaus mokymosi modelius įkvėpė biologinių nervų sistemų informacijos apdorojimo ir komunikacijos modeliai.

K: Kuo giliojo mokymosi modeliai skiriasi nuo biologinių smegenų savybių?

A.: Gilaus mokymosi modeliai daugeliu atžvilgių skiriasi nuo biologinių smegenų, ypač žmogaus smegenų, struktūrinių ir funkcinių savybių, todėl jie nesuderinami su neuromokslų įrodymais.

K: Koks yra kitas gilaus mokymosi terminas?

A: Gilusis mokymasis dar vadinamas giliuoju struktūriniu mokymusi arba hierarchiniu mokymusi.

Ieškoti